成都百度推广_百度网站推广_百度推广公司_百度爱采购

百度SEO优化专家梁水才

-

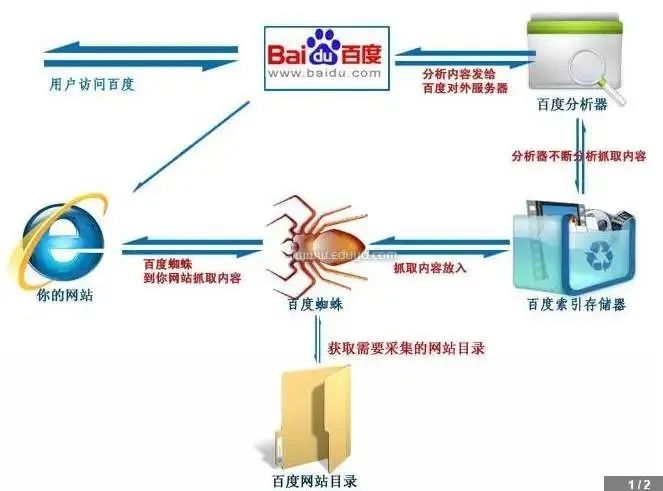

然而,当面对收录效果差的时候,很多伙伴并不知道是为什么,很大程度上是因为不太了解一个关键所在——搜索引擎蜘蛛。什么是搜索引擎蜘蛛?搜索引擎是如何通过蜘蛛对网站进行收录和排名的呢?如何才能提升蜘蛛爬取效果呢?请慢慢看下去。

什么是搜索引擎蜘蛛

确实如同白话理解的一般,互联网可以理解成一张巨大的“蜘蛛网”,搜索引擎蜘蛛是类似实质的“机器人”。蜘蛛的主要任务就是在巨大的蜘蛛网(互联网)中浏览信息,然后把这些信息都抓取到搜索引擎的服务器上,建立索引库。就好比机器人浏览我们的网站,然后把内容保存到自己的电脑上。搜索引擎蜘蛛工作原理

每家独立的搜索引擎都会有自己的网页抓取程序爬虫。爬虫蜘蛛顺着网页中的超链接分析连续访问抓去更多网页。被抓取的网页被称之为网页快照。毋庸置疑,搜索引擎蜘蛛抓取网页是有一定规律的。如下:01

权重优先

先参照链接的权重,再综合深度优先和宽度优先策略抓取。打个比方,如果这条链接的权重还不错,就采用深度优先;如果权重很低,则采用宽度优先。蜘蛛深度抓取。

指蜘蛛发现一个链接进行爬行的过程中,一直向前,直到最深层级不可再爬行为止,然后返回最初爬行页面,再进行下一个链接爬行。就好比从网站的首页,爬行到网站的第一个栏目页,再通过栏目页爬行一个内容页,然后跳出首页,对第二个网站进行爬行。蜘蛛广度抓取。

指蜘蛛爬行一个页面时,存在多个链接,并非对一个链接进行深入抓取,例如:蜘蛛进入网站首页后,对所有栏目页进行有效爬行,再对所有栏目页下的二级栏目或者内容页进行爬行,也就是一层层的爬行方式,不是一个个的爬行方式。2、重访抓取

这个就可以直接从字面上理解。因为搜索引擎使用单个重访与全部重访结合的居多。所以我们做网站内容要记得定期维护日常更新,让蜘蛛多来访多抓取才能收录快。 (百度蜘蛛工作原理图)

(百度蜘蛛工作原理图)

如何提升搜索引擎蜘蛛抓取01

内容更新频率要高

搜索引擎蜘蛛对经常定时更新高价值内容的站点,优先抓。在网站优化中,创建内容要有频率,蜘蛛爬行是有策略的,网站内创建文章越频繁,蜘蛛爬行的频率就会越频繁。一个有新鲜血液的网站才能对蜘蛛有吸引力,才不会认识是个死站。但是要注意,不要一天更新很多内容,第二天又一点内容都不更新。要保持规律性,比如一天定时更新十篇,再循序渐进。这样,才会长久得吸引蜘蛛。对于我们的力欧群站而言,就能很好的做到这点,实现7*24小时常态性、全自动内容更新。力欧群站的研发是基于AI自然语言处理,网站文章内容由AI人工智能全自动完成从内容生产到推送的全过程。每天自动更新数篇文章,更新有助于蜘蛛的爬取。02

服务器稳定,速度快

保持服务器或者虚拟主机的稳定非常重要。从15年开始,百度对于服务器的稳定性因素权值做了一个很大的提升。服务器稳定包括稳定和速度两个方面。速度越快的服务器,蜘蛛抓取的效率越高。服务器越稳定,蜘蛛抓取的连通率就越高。目前,也有很多搜索引擎将网页的打开速度做为PR的参考因素,因此力欧群站的研发是建立在具备高速稳定的服务器之上,采用先进的网页技术标准,能使网页打开速度<2秒,超过全国90%的网站。不仅能使潜在目标客户有很好的体验感,还能使蜘蛛爬行得很轻松,下次当然乐意来。

03

内链结构好+优质入口

检查内部链接结构,去除死链和重复链接,这个是SEO的基本要求,并且内部链接对于PR的提升有相当的作用。

这里说的入口,指的是网站的外链。优质站点follow(跟踪)的站点,优先抓。现在百度对外链部分做了很大调整,对于垃圾外链,百度已经过滤的非常严格了。基本上论坛发外链或者留言板之类的外链,百度都会在后台过滤。但是真正的高质量的外链,对于排名和抓取来说还是非常有作用的。

04

网络层次结构要利于蜘蛛爬行

网络层次结构要利于蜘蛛爬行,必须先有一个清晰的层次结构。树结构是一个理想的站点结构、蜘蛛能很好的理解和爬行。首页-索引页面——在形式的内容页面给用户在最短的时间内找到的信息需求。因为相关内容在同一列,可以提高聚合度,从而更有利于蜘蛛爬行集成。

05

其他操作细节

用Google站长工具检查爬行速度。检测网页结构是否合理,结构良好的网站也会对蜘蛛爬行有良好的促进作用。另外,可以为每个页面制作独立的标题和meta标签(关键字、描述)。不过要注意不要堆砌关键词。

以上就是本次对蜘蛛抓取的相关分享,后续我们也将不间断分享更多。大家在做网站优化运营工作时多注意文中所述的细节,一定会让蜘蛛更容易抓取我们的页面,从而提高网站的收录、排名。支付宝

微信

来源:梁水才博客(微信/电话:13408614686),转载请保留出处和链接!